Suivez ce processus d’audit SEO en 16 étapes pour améliorer le référencement de votre site et booster votre trafic de recherche.

La plupart des audits SEO ont deux choses en commun :

- ils sont trop techniques ;

- il faut compter plusieurs JOURS (voire des SEMAINES) pour les terminer !

Ce que nous proposons est différent.

Cela prend seulement des heures, non des semaines. Puis, vous n’avez pas besoin d’un diplôme en informatique pour les réaliser.

Remarque : Si vous avez un grand site avec de centaines de milliers, voire de millions de pages, cela peut prendre plus de quelques heures. Mais, pour la plupart des sites de petite à moyenne taille, vous pouvez les réaliser en quelques heures plutôt qu’en jours.

Voici les étapes d’un audit SEO que nous suivrons :

- Étapes 1 à 4 : recherchez les GRANDS problèmes (qui peuvent bloquer votre site)

- Étapes 5 à 9 : recherchez les problèmes faciles à résoudre sur le site

- Étapes 10 à 12 : analysez le trafic de recherche organique (et trouvez des opportunités à faible potentiel)

- Étapes 13 à 14 : analysez les backlinks (TRÈS important !)

- Étapes 15 à 16 : auditez le contenu et analysez les « lacunes de contenu ».

Comme vous pouvez le voir, l’objectif n’est pas de vous montrer comment faire un audit SEO « technique » (que vous pouvez faire avec presque n’importe quel outil d’audit SEO).

Le but est de proposer une approche globale de l’audit de votre site Internet dans une perspective SEO. En d’autres termes, cela consiste à auditer vos classements, votre profil de backlink, votre contenu existant… tout ce qui pourrait nuire à vos performances de recherche.

Vous recherchez un audit SEO encore plus simple pour les débutants ? Regardez cette vidéo.

Alors, commençons !

Remarque : La version originale de cet article a été écrite par David McSweeney en 2016. Mais, nous avons fait une ÉNORME réécriture en 2018.

Néanmoins, je voulais m’assurer que David reçoive au moins un certain crédit pour son travail, car l’original était FANTASTIQUE. J’espère que cette version mise à jour pourra lui rendre justice.

Les outils nécessaires pour l’audit SEO

Voici les outils que j’utiliserai au cours du processus d’audit SEO :

- Google Analytics

- Google Search Console

- Google PageSpeed Insights

- Outil de test des données structurées de Google

- SEMrush ou ahrefs (essai de 7 jours)

- Copyscape

- SERP Simulator

- Web Page Word Counter

Avoir tous ces outils n’est pas important, mais ils faciliteront le processus.

Remarque de l’éditeur

Pour cette présentation, j’auditerai deux sites.

Aux étapes 1 à 9, nous allons examiner Simple Life Insure, un site d’assurance-vie de Californie.

Je présenterai le deuxième site avant l’étape 10.

Commençons !

Étape 1. Vérifiez qu’une seule version de votre site Web est disponible

Dans un instant, je vais vous montrer comment commencer à auditer votre site pour trouver les problèmes SEO.

Mais avant cela, vous devriez vérifier qu’une seule version de votre site est disponible.

Imaginez toutes les possibilités dont quelqu’un pourrait saisir l’adresse de votre site Web dans un navigateur (ou un lien vers celui-ci).

Par exemple :

- http://votredomaine.com

- http://www.votredomaine.com

- https://votredomaine.com

- https://www.votredomaine.com

Seul UN d’entre eux doit être accessible dans un navigateur.

Les autres devraient être 301 redirigés vers la version canonique.

Pour Simple Life Insure, tout est normal.

Vous pouvez vérifier que si nous tapons la version HTTP dans la barre d’adresse, elle redirige automatiquement vers la version HTTPS.

Il en va de même pour la version www. Elle redirige vers la version non www.

Pour être honnête, la redirection de non-www vers www (ou vice-versa) est rarement un problème. Cependant, j’ai vu beaucoup de sites avec des problèmes de redirection de http vers https.

Même mon blog rencontre ces problèmes !

Alors, vous devriez les résoudre en priorité.

Remarque : Assurez-vous également de tester d’autres URLs sur votre site pour voir si les redirections 301 sont mises en œuvre sur l’ensemble du site.

Si tout va bien, notez la version canonique (par exemple, https://simplelifeinsure.com) et passez à l’étape 2.

Recommandation

Nous vous recommandons d’utiliser https:// (que ce soit pour www ou non www), car il y a une légère augmentation du classement pour les sites protégés par SSL.

De plus, ce certificat protège également votre site et augmente la confiance.

Let’s Encrypt peut vous donner gratuitement un certificat SSL pour votre site.

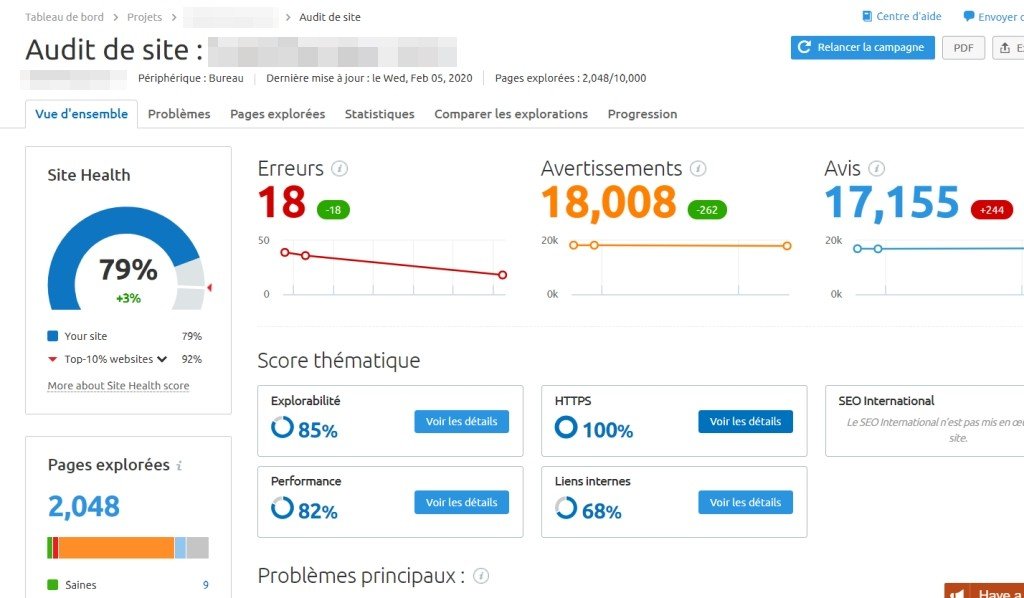

Étape 2. Commencez par analyser votre site Web

Dans un instant, nous allons faire quelques vérifications manuelles supplémentaires sur le site Web.

Mais avant cela, nous allons d’abord commencer par analyser le site Web en arrière-plan.

Un crawler SEO va auditer le site de la même manière que Google. Il nous donnera par la suite quelques informations utiles sur la structure et la configuration SEO actuelle.

Il y a plusieurs outils d’analyse SEO capables de le faire, tels que :

- Screaming Frog (149 £/an) ;

- Beam Us Up (Gratuit)

Ce sont deux excellentes options. Mais dans cet exemple, nous allons utiliser le Site Audit d’Ahrefs. Il est possible d’utiliser l’outil SEMRUSH qui supporte la langue française.

Allez dans « Site Audit », puis « Nouveau projet » et collez le domaine dans la section « Scope & seeds ». Décochez toutes les redirections 301.

Pour Semrush aller sur Projet > Ajouter un nouveau projet

Appuyez sur « Suivant » dans hrefs et Commencer avec Semrush

En général, vous pouvez laisser les autres paramètres tels quels.

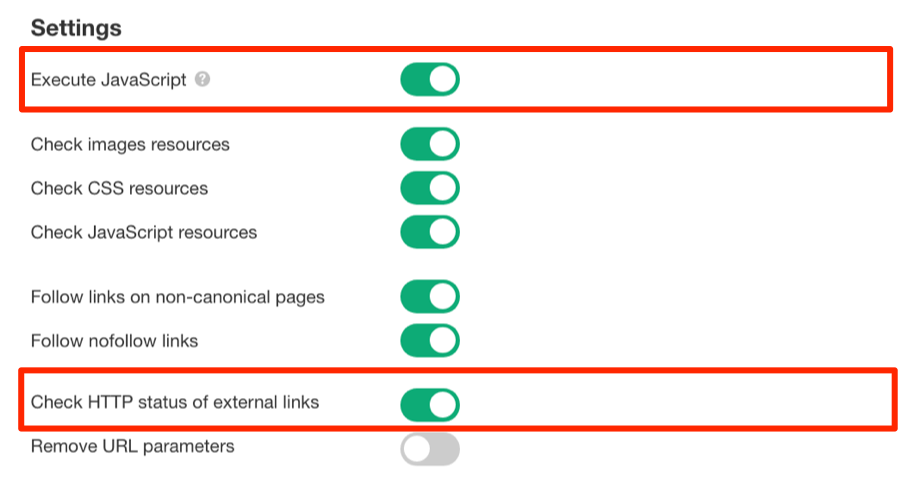

Mais, je vous recommande d’activer les options « Vérifier le statut HTTP des liens externes » et « Exécuter JavaScript » (dans les Paramètres d’audit) si vous utilisez l’outils hrefs.

Ainsi, l’audit du site va également vérifier tous les liens externes sur votre site Web et tous les liens JS.

Lorsque vous avez terminé, cliquez sur « Créer un projet ». La fonction Audit de site va fonctionner en arrière-plan pendant que nous poursuivons l’audit SEO.

Voici une démo de tout ce processus d’audit SEO avec ahrefs:

Et voici un court tutoriel sur comment faire un audit SEO en utilisant l’outil SEMrush

Étape 3. Vérifiez les problèmes d’indexation dans Google

Ne pas être indexé dans Google = pas de classement… ça jamais !

Pour vérifier que votre site est indexé, allez sur :

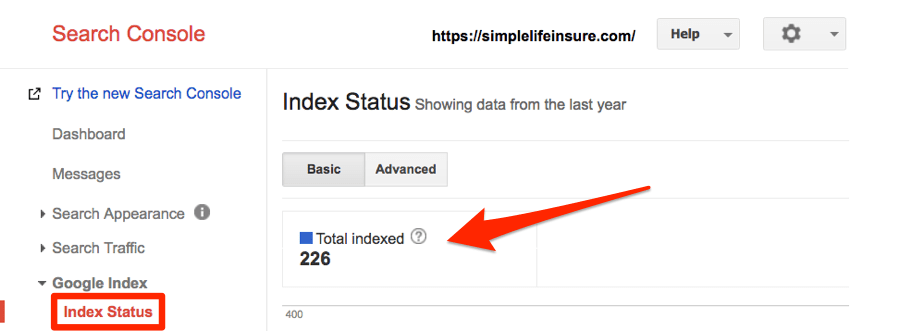

Google Search Console, puis Index Google ensuite Statut de l’index.

Vous n’utilisez pas Google Search Console ?

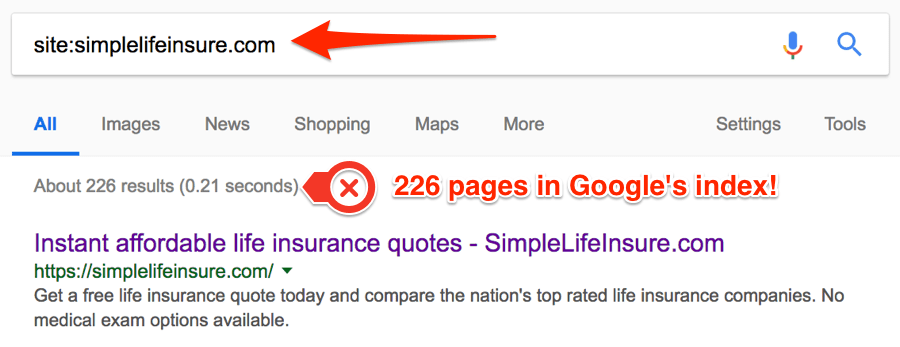

Pas de soucis, recherchez dans les « opérateurs de recherche Google » à partir du « site:… ».

Exemple :

site:simplelifeinsure.com

Le résultat affichera également le nombre de pages indexées par Google pour votre domaine. Toutefois, ce n’est pas toujours aussi précis qu’avec Search Console.

Pour simplelifeinsure.com, Google a 226 pages indexées.

Vous ne voyez aucune page indexée ? Alors, lisez ceci.

Si vous ne voyez aucun résultat pour cette recherche, vous avez des problèmes.

Cela signifie qu’aucune page de votre site n’est indexée. En d’autres termes, il n’y a aucun trafic organique.

Ce problème est généralement dû à un entête HTTP x‑robots-tag.

Pour le vérifier, il faut accéder au fichier header.php, .htaccess ou au serveur de votre site.

Dans cet article, vous explique tout ce que vous devez savoir à ce sujet.

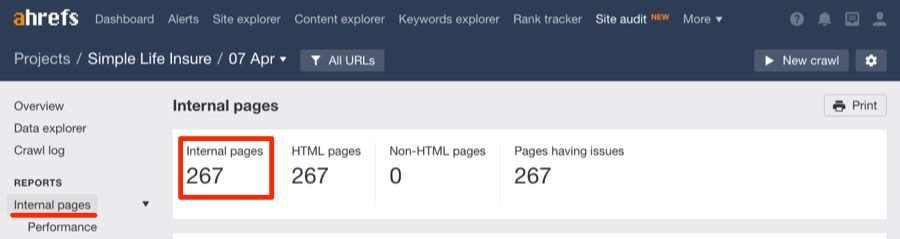

Cela vaut la peine de croiser ce nombre avec le nombre de pages internes trouvées lors de l’audit du site (celui que nous avons configuré à l’étape 1).

Vous devrez bien sûr attendre que cela se termine avant de le faire.

Pour ce faire, allez sur :

Site Audit puis Projet ensuite Pages internes.

Hmm, il paraît que notre audit ait découvert 267 pages, alors pourquoi seules 226 pages sont indexées ?

Tout d’abord, je pense que certaines de ces pages ne sont pas indexées. Allons vérifier.

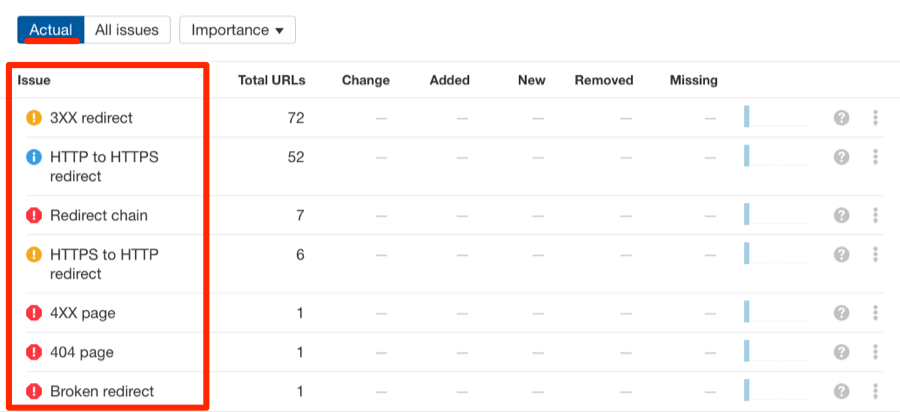

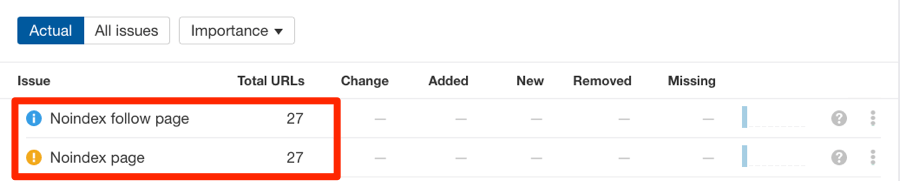

Faites défiler vers le bas, puis vous verrez une liste des erreurs trouvées pendant l’audit.

Apparemment, là il n’y a pas de problème, car l’analyse n’a découvert aucune balise « noindex ».

Remarque de l’éditeur :

Voici ce que vous verriez si l’audit a découvert des balises « noindex » sur certaines pages :

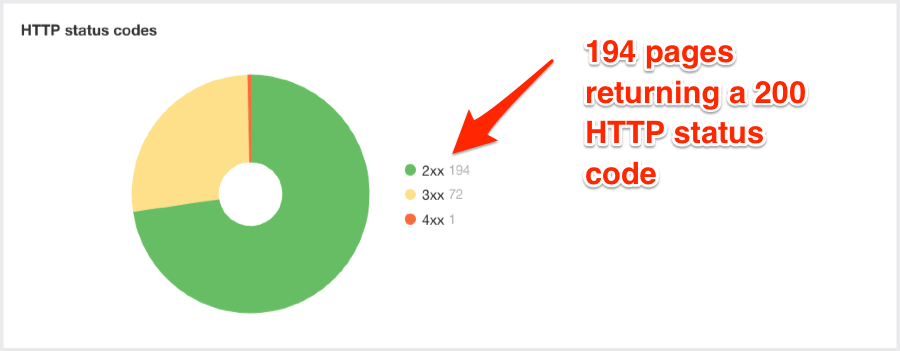

Faisons défiler vers le bas et vérifions les codes de statut HTTP pour les 267 pages.

Maintenant, il paraît que nous avons trouvé la raison de cet écart : seules 194 pages sont des pages actives (soit 200 statuts HTTP) ; les autres sont des redirections ou des pages cassées.

Mais là, nous avons un autre problème … il y a plus de pages indexées dans Google que de pages actives sur le site.

Alors, qu’est-ce que ça donne ?

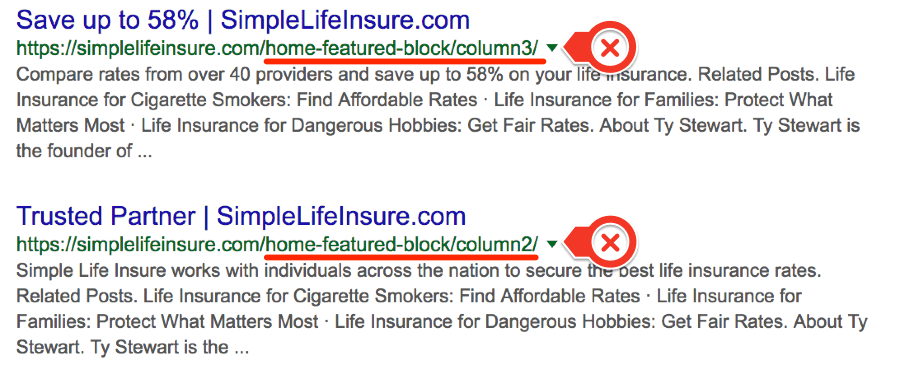

Si nous revenons au site, recherchons et parcourons les pages, voici ce que nous allons voir :

Nous voyons que Google indexe les éléments de la page d’accueil en tant que pages différentes.

Celles-ci n’ont pas de contenu. En fait, elles sont cassées ! et doivent être supprimées de l’index.

Étape 4. Vérifiez que vous êtes classé pour votre nom de marque

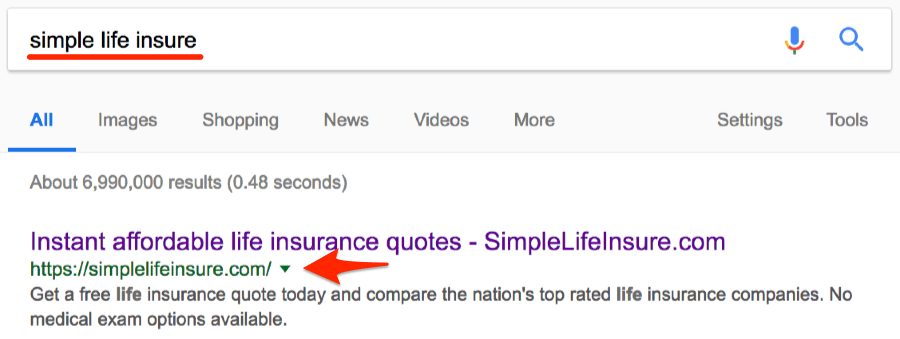

Accédez à Google et recherchez votre nom de marque.

À moins que votre site soit très récent (ou que la marque soit une expression très générique), je m’attendrais à ce que votre site soit le premier résultat organique.

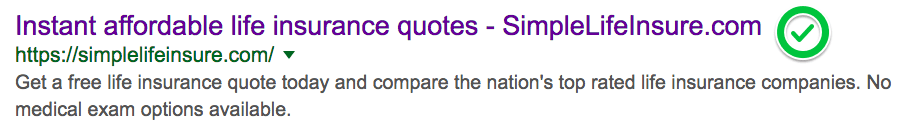

Exemple :

Je m’attendrais aussi à voir votre page d’accueil dans le premier résultat.

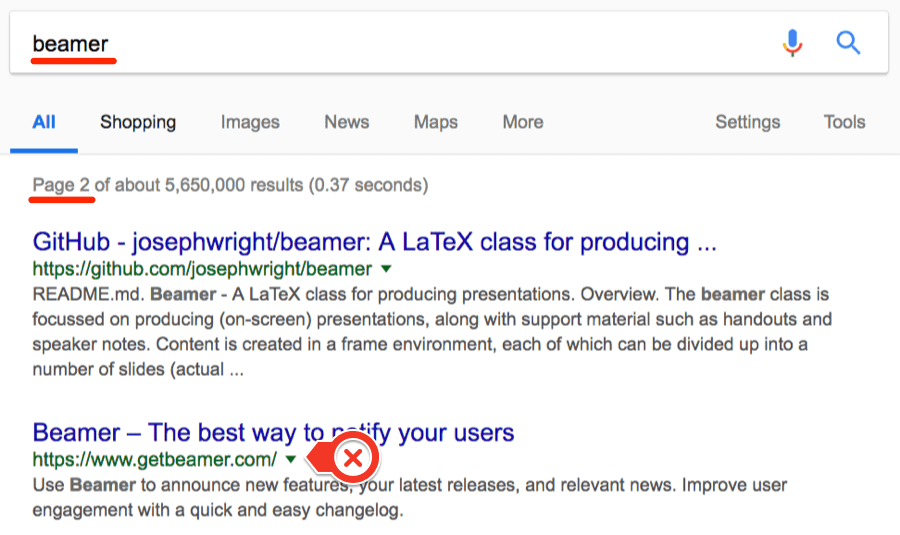

Si vous ne vous situez pas en première position, mais plus bas dans les résultats, Google pense sans doute qu’un autre site est beaucoup plus approprié comme résultat pour ce terme de marque.

Prenons Beamer comme exemple.

Il semble qu’il soit actuellement en 12e position pour le terme de marque « beamer ».

Vous rencontrez ce genre de problème lorsque vous utilisez un mot générique comme nom de marque.

C’est difficile de le classer, car la plupart des gens ne souhaitent pas tomber sur votre site Web lorsqu’ils recherchent le terme « de marque ».

Alors, quelle est la solution ?

Créer une marque et créer des liens.

En d’autres termes, il faut :

- Créer des liens solides et de marque ;

- Lancer une campagne de relations publiques (c’est-à-dire, être mentionné et lié à de grands sites Web bien connus)

- Créer certaines citations sur les activités annuaires ;

- S’assurer que le site dispose d’une fiche Google Business ;

- Assurer que le site soit présent sur tous les principaux réseaux sociaux.

Appliquez toutes ces mesures, et vous devriez lentement gravir les échelons.

Souvenez-vous que l’intention du chercheur est d’apparaître dans le premier résultat.

Si la plupart des personnes qui recherchent le terme «de marque » recherchent votre entreprise, alors Google va commencer à rétrograder les autres sites et à vous pousser vers le haut.

Mais, que faire si vous n’apparaissez même pas dans les SERPs ?

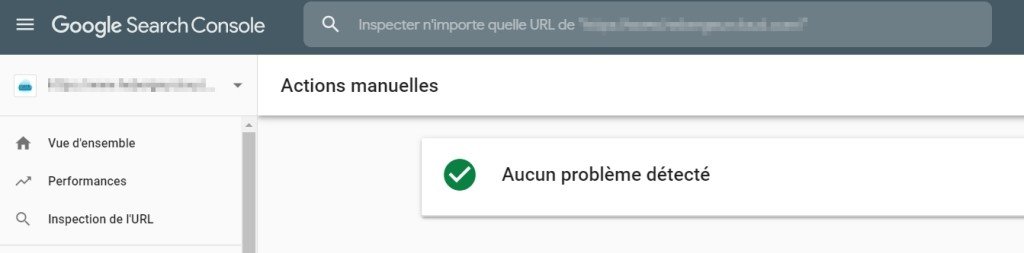

Si vous avez résolu les problèmes d’indexation (que vous devriez avoir !), ne pas apparaître dans les SERPs signifie que vous avez de sérieux problèmes, tels que de lourdes pénalités algorithmiques ou manuelles.

Je vous recommande de vérifier Google Search Console pour toute indication de sanctions.

Idéalement, voici ce dont vous devez voir :

Étape 5. Vérifiez manuellement le SEO de base de la page

Vérifiez tout d’abord quelques principes fondamentaux sur la page.

Commencez par la page d’accueil. Mais, vous devriez aussi le faire pour les autres pages importantes de votre site.

Voici comment trouver les pages les plus importantes de votre site…

Juste pour clarifier les choses, quand je dis « les plus importantes », je veux dire les pages qui reçoivent le trafic de recherche le plus organique.

Si vous avez utilisé le Site Audit d’Ahrefs pour auditer votre site, vous pouvez facilement les trouver en allant sur :

Site Audit, puis Projet ensuite Pages internes et triez par trafic organique.

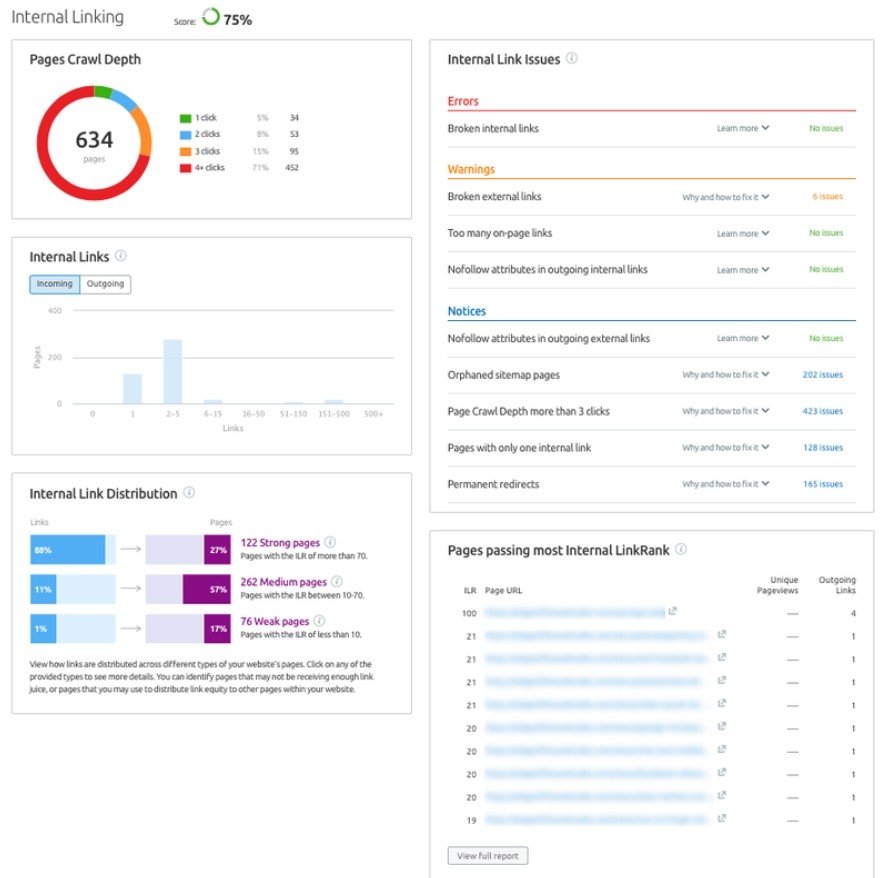

Voici comment faire pour auditer les liens internes avec SEMrush:

Nous allons accéder à la page d’accueil du site dans un navigateur ensuite cliquer avec le bouton droit pour afficher la source.

Là, nous allons juste vérifier rapidement quelques SEO de base sur la page.

Pour vous faciliter la tâche, répondez à ces quelques questions :

- La page a-t-elle une balise de titres cliquable et bien conçue ?

- Y-a-t-il une méta description personnalisée ? Est-ce optimisé pour maximiser les clics ?

- Y-a-t-il une seule instance de la balise H1 ? Est-ce bien optimisé ?

- Les sous-entêtes (H2, H3, etc.) sont-ils utilisés correctement ?

Remarques : John Mueller de Google a précédemment déclaré que la présence de plusieurs balises H1 sur une page Web n’était pas un problème.

Pourtant, nous pensons que le mieux est d’en ajouter une seulement. Avoir plusieurs entêtes n’est pas seulement nécessaire à des fins SEO, mais cela peut aussi paraître gênant et déroutant pour vos visiteurs.

Alors, vérifions la balise de titre.

<title>Instant affordable life insurance quotes - SimpleLifeInsure.com</title>

Tout d’abord, assurons-nous qu’elle n’est pas tronquée dans les résultats de recherche.

Apparemment, tout me paraît normal !

Remarque : Voici un outil que vous pouvez utiliser pour vérifier la longueur de la balise de titre en pixels. Cela vous évite de devoir vérifier manuellement dans les SERPs.

La balise de titre est aussi bien écrite, et je pense que cela va attirer des clics.

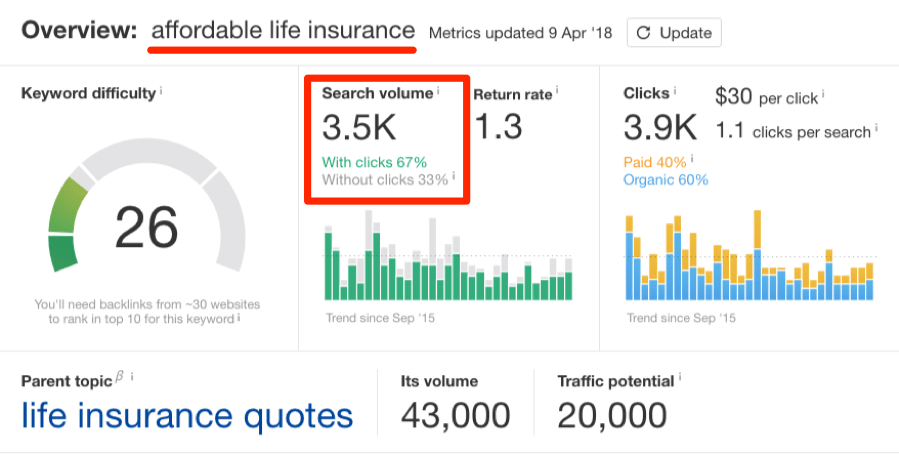

Mais contient-elle un mot clé pertinent avec un bon volume de recherches ?

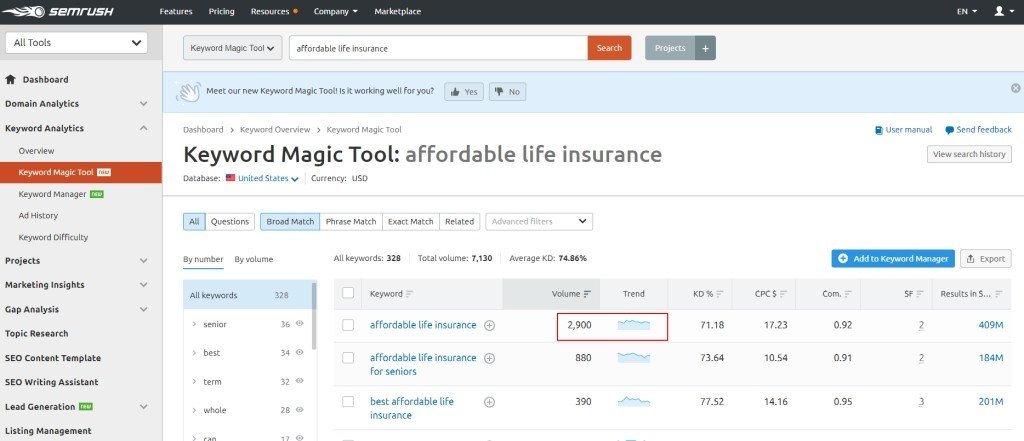

Vérifions le volume de recherches de l’« assurance-vie abordable » dans Keywords Explorer d’Ahrefs.

Dans SEMrush allez sur : Keyword Overview ensuite cliquer sur Keyword Magic Tool

Ce n’est pas mal !

Mais il s’avère qu’il y a plus de volume de recherches pour le sujet parent : « devis d’assurance-vie ».

Je pense que Simple Life Insure doit être un utilisateur d’Ahrefs, car il a déjà intégré ce mot-clé de manière transparente dans sa balise de titre.

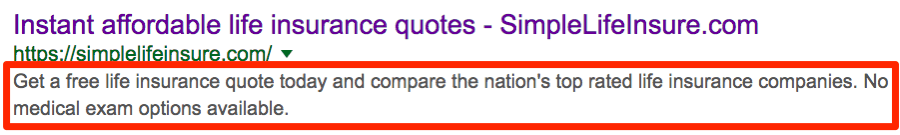

Maintenant, passons à la méta description.

Il est important de noter que la méta description influence votre classement indirectement.

En effet, une méta description bien écrite et attrayante peut vous aider à obtenir plus de clics.

Remarque : Si nous pensons que le CTR est un facteur de classement (il l’est presque certainement), alors les méta-descriptions peuvent affecter indirectement les classements.

En d’autres termes, si une méta description bien écrite conduit à une augmentation du CTR, cela aura probablement des répercussions positives sur les classements.

Considérez-la comme votre annonce dans les résultats de recherche.

Une bonne méta description devrait parler des principaux USP du produit ou service que vous proposez.

A titre d’exemple, un site e-commerce peut inclure des points tels que « livraison GRATUITE », « retours sans problème », « prix les moins chers », etc.

Voici la méta description actuelle de la page d’accueil de Simple Life Insures :

Je pense que c’est un très bon travail.

Aucun changement n’est donc nécessaire.

Vérifions les entêtes (et sous-entêtes).

La balise H1 est toujours un facteur de classement important pour la page.

Il est donc recommandé d’utiliser une seule balise H1 unique et descriptive sur chaque page.

Remarque : Pour rappel, avoir plusieurs balises H1 n’est pas vraiment un problème, selon Google. Mais je recommande toujours de viser une seule balise H1 par page.

Pour la page d’accueil, vous devrez :

- Parler de l’objectif principal du site ;

- Ajouter 1 ou 2 mots clés très pertinents dans la balise.

Voici la balise H1 actuelle :

<h1>Comparez les devis d'assurance-vie abordable en 1 minute</h1>

C’est parfait ! Il paraît qu’ils aient ajouté à la fois « assurance-vie abordable » et « devis d’assurance-vie » dans leur balise H1.

Mais, qu’en est-il des sous-entêtes ?

Les sous-entêtes doivent être utilisés de manière logique pour diviser le contenu de chaque page. Puis, ce sont aussi d’excellente occasion de cibler des mots clés/expressions secondaires.

Evitez d’utiliser des expressions génériques (« plus d’informations », « détails », etc.) dans les sous-entêtes.

La page d’accueil de Simple Life Insures utilise bien les sous-entêtes et n’a pas besoin d’aucune modification.

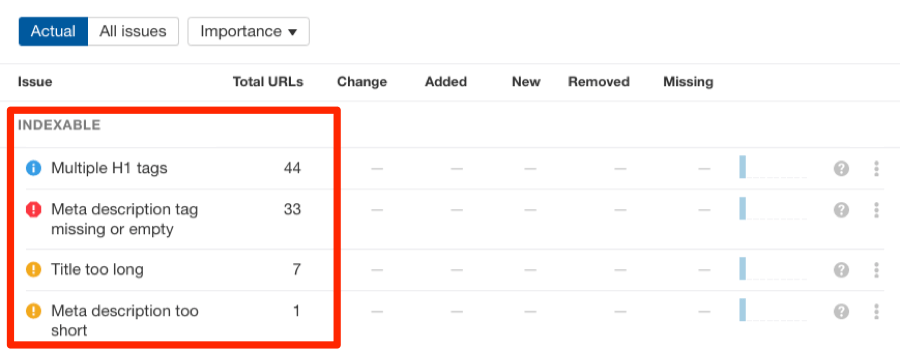

Étape 6. Analysez en profondeur les problèmes sur la page dans le rapport d’audit

À moins que vous avez un grand site, votre rapport d’audit dans le Site Audit d’Ahrefs ou avec SEMrush devrait être terminé maintenant.

Alors, il est temps d’analyser plus profondément et de résoudre tout autre problème important sur la page.

Allez sur Site Audit, puis Projet ensuite Pages internes et Balises HTML.

Voici une liste de tous les problèmes trouvés sur la page pendant l’audit.

SEMrush offre un meilleur rapport. Il catégorise les erreurs en fonction de leurs degrés d’importance.

Pour hiérarchiser vos efforts, filtrez-les par ordre d’importance.

Je recommande de corriger d’abord toutes les Erreurs importantes avant de passer aux Avertissements et Avis.

Vous pouvez aussi consulter les rapports Social Tags, Content Quality et Outgoing Links pour vous assurer que tous les problèmes sur la page sont résolus.

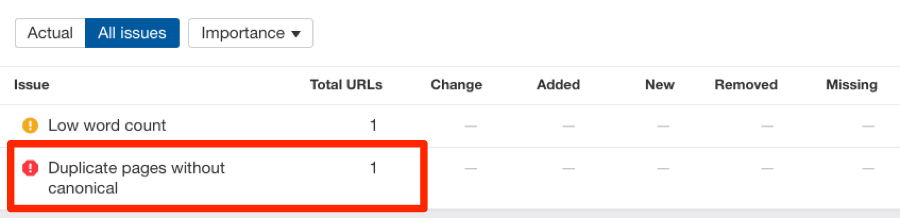

Étape 7. Vérifiez le contenu dupliqué et de moindre qualité (thin contentn)

Google déteste le contenu dupliqué.

Si vous en avez trop, votre site peut être pénalisé par Panda.

Avoir un contenu dupliqué sur plusieurs pages de votre site n’est pas bon. Mais, lorsqu’il est dupliqué sur d’autres sites Web, c’est encore pire.

Conseil : recherchez le contenu en double sur votre propre site en quelques secondes.

Pour ce faire, allez sur :

Site Audit, Projet, puis Pages internes et Qualité du contenu.

Recherchez les erreurs « pages dupliquées non-canoniques ».

Cliquez sur l’élément de problème pour voir les URL exactes ayant causé ce problème, puis corrigez-les.

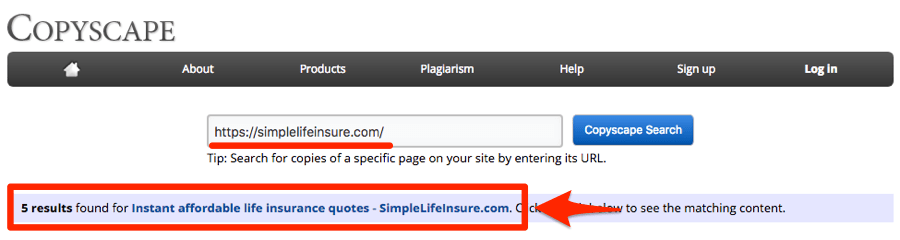

Vous pouvez facilement trouver les sources des problèmes de contenu en double sur le Web en utilisant Copyscape.

Entrez une URL, et cet outil va afficher tous les contenus en double.

Remarque : Si vous souhaitez vérifier toutes les pages de votre site, vous pouvez le faire avec un compte Copyscape premium. Le tarif commence à 3 cents par recherche et vous pouvez vérifier jusqu’à 10 000 URLs à la fois.

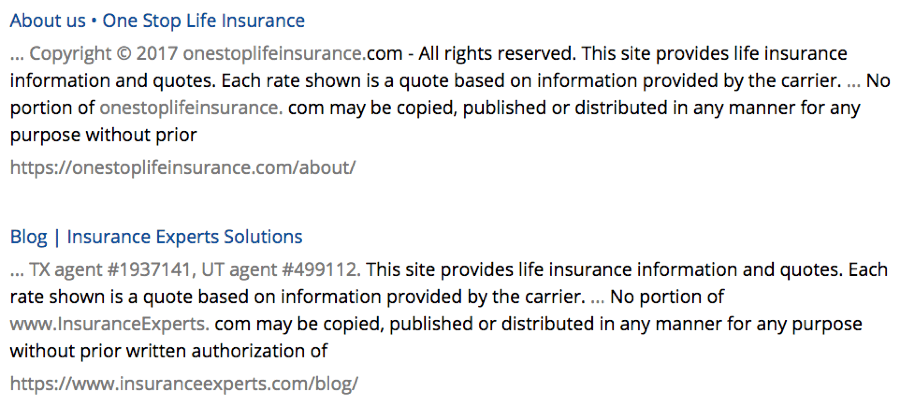

Pour cette recherche particulière, il y a cinq résultats.

Analysons plus profondément la cause de ce contenu en double.

Il paraît que le problème soit lié au texte de la clause de non-responsabilité dans le pied de page du site.

Il est signalé parce que de nombreux autres sites utilisent le même texte de clause de non-responsabilité.

(En toute honnêteté, c’est sans doute un modèle de clause de non-responsabilité que tout le monde utilise.)

Il n’y a rien à craindre.

Il ne faut pas s’inquiéter que si d’autres sites Web a volé de grandes quantités de contenu d’un site Web, tels que des articles de blog entiers.

Là, le problème se pose. Il se peut que Google soit confus de savoir qui est l’auteur original du contenu, ce qui entraîne un classement de la mauvaise version de la page.

Si vous remarquez un contenu « volé » ou syndiqué comme celui-ci, assurez-vous que la version en double renvoie au contenu original sur votre site (idéalement avec un lien rel=”canonique”).

Quoi qu’il en soit, le contenu en double n’est pas le seul problème lié au contenu que vous devez connaître.

Le contenu mince ou pauvre (par exemple, les pages avec très peu de contenu écrit ou manquent de qualité) peut également poser un problème.

En effet, elles offrent peu ou pas de valeur. Par conséquent, elles ont souvent du mal à se classer.

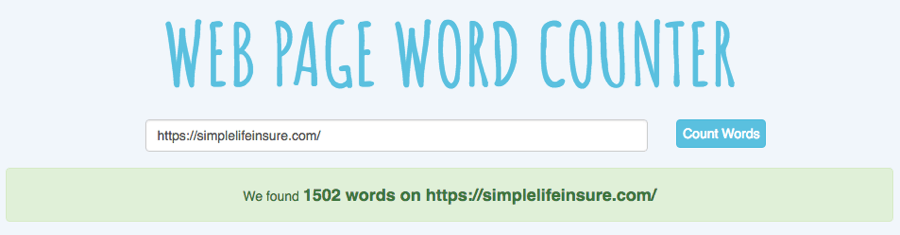

Vous pouvez utiliser un outil comme celui-ci pour trouver manuellement le contenu mince ou pauvre.

Entrez l’URL et le nombre de mots sera donné.

Je me méfierais de tout ce qui est au-dessous de 200 mots.

Dans la plupart des cas, ces pages doivent être « améliorées » ou supprimées.

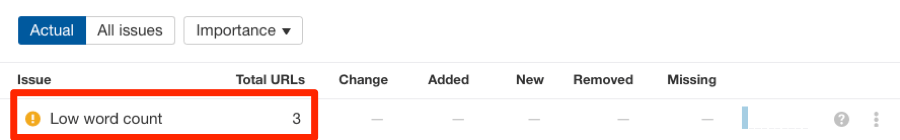

Conseil : trouvez tout le contenu de moindre qualité sur votre site

Pour cela, allez sur :

Site Audit, puis Projet ensuite Pages internes et Qualité du contenu.

Recherchez les erreurs de « faible nombre de mots ».

Le résultat va afficher toutes les pages contenant moins de 50 mots.

Cliquez sur l’icône « ? » pour avoir plus d’informations sur les correctifs possibles pour résoudre ce problème.

Étape 8. Vérifiez que votre site (et vos pages individuelles) se chargent RAPIDEMENT

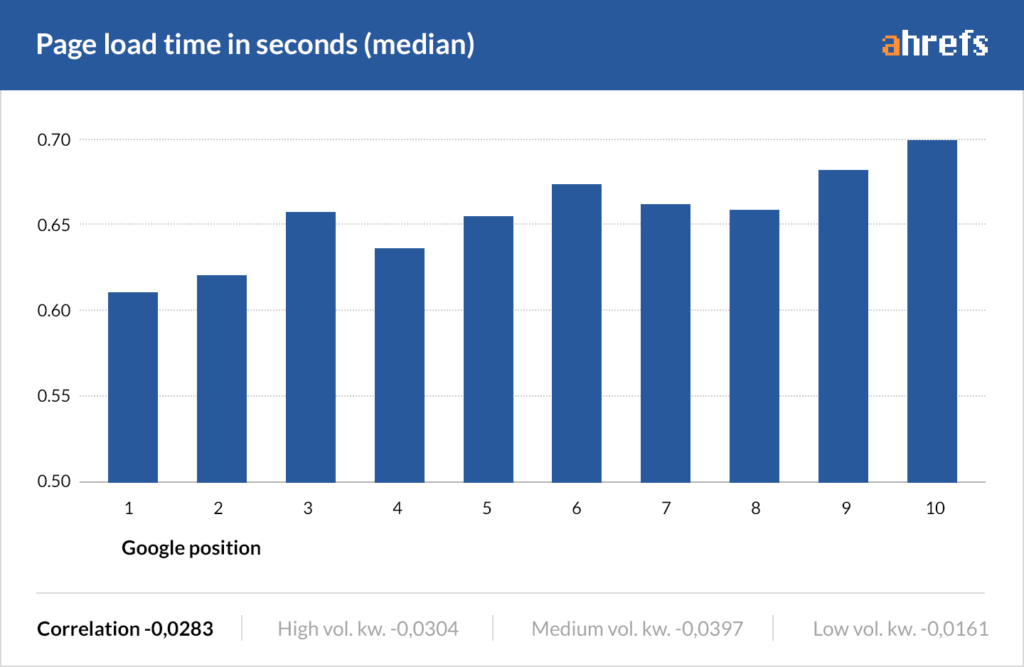

Il a longtemps été confirmé que la vitesse du site est l’un des plus grands facteurs de classement de Google.

Nous avons également étudié 2 millions de pages et remarqué qu’il y a une petite corrélation entre le temps de chargement des pages et le classement de Google.

Remarque : Rappelez-vous, « corrélation » est différente de « causalité ».

D’après ces études, il est clair qu’un site avec un temps de chargement rapide offre une meilleure expérience utilisateur qu’un site avec un temps chargement lent.

Il est donc recommandé de veiller à ce que votre site Web se charge le plus rapidement possible.

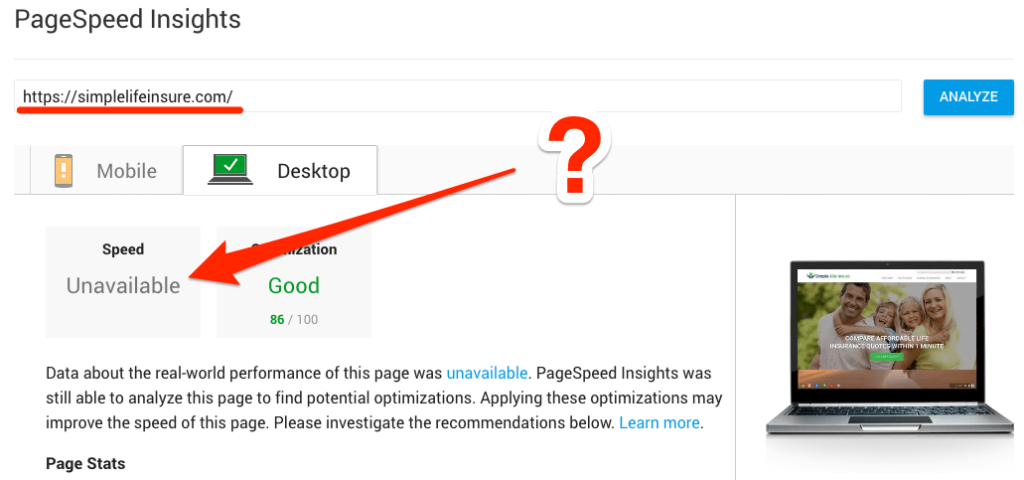

L’outil PageSpeed Insights de Google est un bon point de départ pour connaître votre situation actuelle. Mais, il contient quelques fois des erreurs.

Oh, « vitesse indisponible » ! Très utile … NON.

Je constate de plus en plus ce résultat, en particulier pour les petits sites Web à faible trafic.

Je recommande donc d’utiliser un autre outil, tel que :

- Pingdom ;

- GTMetrix ;

- Site Audit de SEMrush

Etant donné que nous avons déjà fait un audit complet de ce site, utilisons le Site Audit d’Ahrefs.

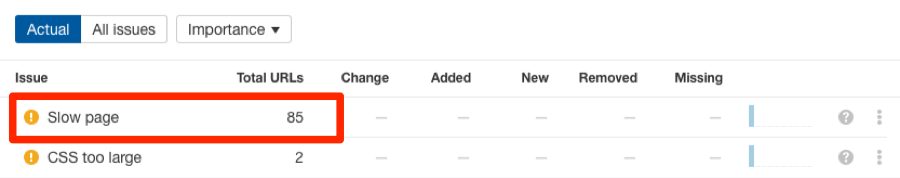

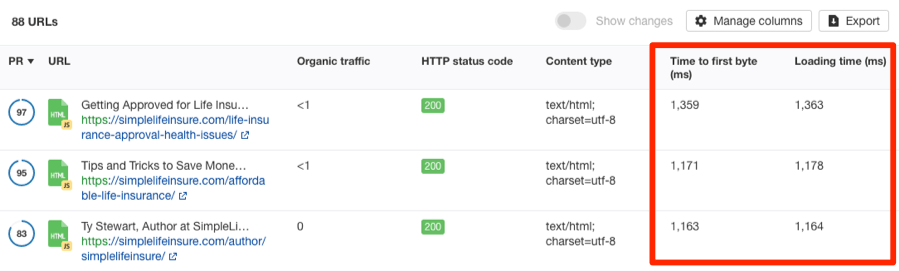

De plus, l’un des avantages d’utiliser Site Audit est que cet outil vous évitera aussi de vérifier minutieusement et manuellement chaque page.

Allez sur Site Audit, puis Pages internes ensuite Performance.

Là, vous verrez tous les problèmes de page lente sur votre site.

Pour voir quelles pages ont de problèmes de chargement lent, cliquez simplement sur l’élément de problème.

Ainsi, vous verrez le temps de chargement du premier octet ou TTFB (ms) et le temps de chargement (ms).

Puis, vous devez optimiser ces pages à chargement lent.

Pour en savoir plus sur l’importance de la vitesse du site pour le SEO et pour obtenir d’excellents conseils sur la façon d’optimiser votre site, consultez ce guide d’Albert Costill pour Search Engine Journal.

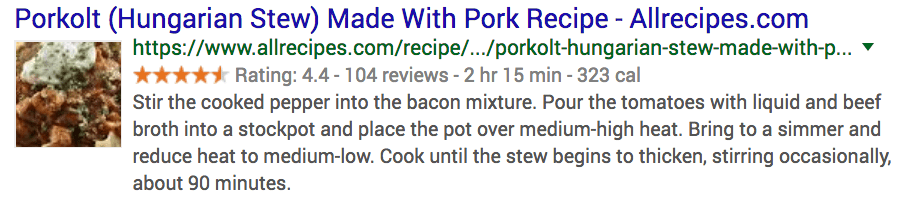

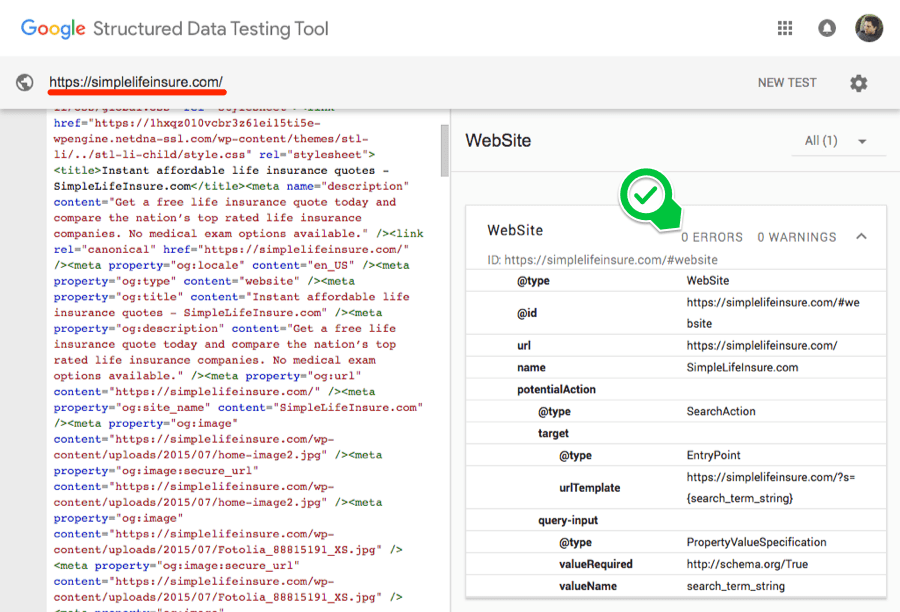

Étape 9. Vérifiez les erreurs de données structurées

La prochaine étape de notre processus d’audit sera de tester toutes les données structurées sur le site. Ensuite, vous devez vous assurer qu’elles soient correctement formées.

Vous ne connaissez pas les données structurées ?

Voici un exemple de son apparence dans les SERPs :

Remarque : Il existe plusieurs types de balisage structuré, alors il vaut mieux consulter le guide de Google sur les données structurées.

Voici quelques exemples de contenu pouvant profiter de la mise en place de données structurées :

- Commentaires ;

- Information produit ;

- Événements

Quoi qu’il en soit, vous pouvez toujours baliser n’importe quel type de contenu, mais ne faites pas de spam !

Nous allons utiliser l’Outil de test de données structurées de Google pour tester les données structurées existantes.

Collez l’URL que vous voulez tester et cliquez sur « Lancer le test ».

Google va analyser les données structurées de la page et renvoyer toutes les erreurs.

Dans ce cas, nous allons voir qu’il n’y a pas d’erreur. (C’est Parfait !)

Si vous trouvez des erreurs, il va sans dire que vous devez les corriger. Ce guide est un bon point de départ pour ce faire.

Remarque de l’éditeur

Pour la prochaine partie du processus d’audit, nous allons analyser le blog d’Ahrefs.

La raison en est que nous avons besoin d’accéder aux données de Google Analytics et de la Search Console.

Étape 10. Analyser le trafic organique

De toute évidence, tout audit SEO vise à trouver les moyens d’augmenter le trafic d’un site Web.

Il est donc logique de jeter un œil à la performance actuelle du site.

Nous allons exécuter quelques rapports dans Google Analytics pour avoir un aperçu rapide.

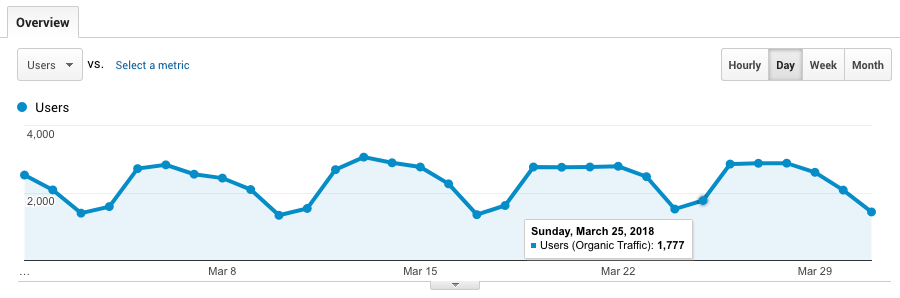

Tout d’abord, nous allons examiner le trafic organique actuel du site.

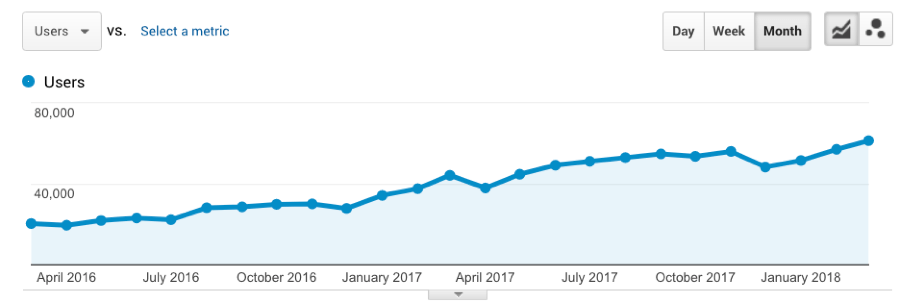

En mars 2018, des données montrent une moyenne de recherche d’environ 1800 visiteurs par jour.

Allez sur Acquisition, puis Aperçu et Recherche organique.

Remarque : Le blog d’Ahrefs reçoit régulièrement plus de 100 000 visites par mois, dont environ 50 % proviennent de la recherche organique.

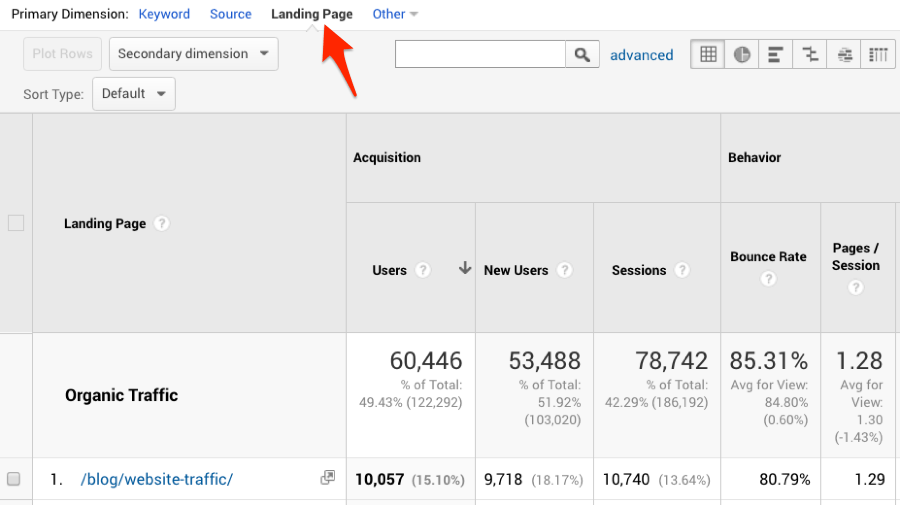

Avec le même rapport, nous pouvons cliquer sur « Page de destination (Landing Page) » pour savoir quelles pages génèrent actuellement le plus de trafic de recherche.

Avoir un grand nombre de pages de destination (dans cet exemple, il y en a 269) suggère que le site est en bonne santé.

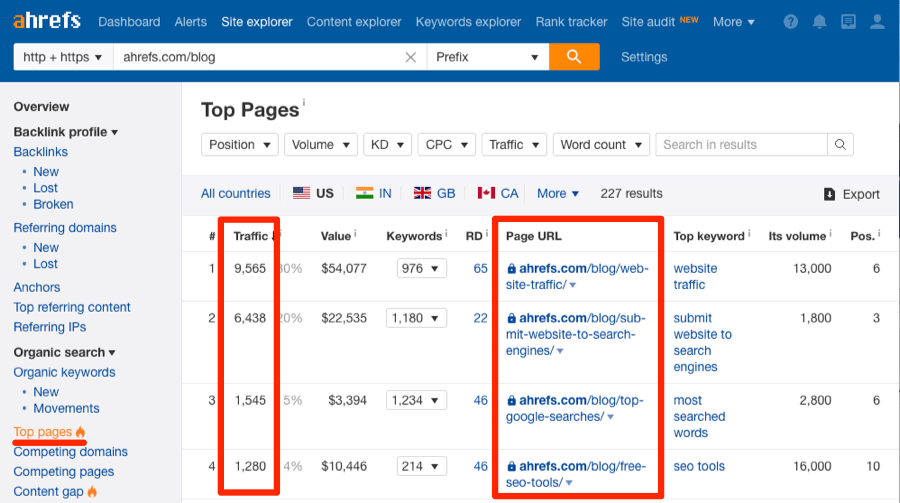

Allez sur Site Explorer puis entrez votre domaine. Cliquez sur Recherche organique ensuite Top pages.

Vous verrez les pages de votre site qui reçoivent le trafic de recherche le plus organique.

Puis, vous pouvez aussi voir le « top mot clé » pour chaque page. C’est le mot clé responsable de l’envoi du trafic de recherche le plus organique vers chaque page.

Ensuite, nous allons définir un large panel (je vais remonter de deux ans en mars 2016) et afficher le trafic par mois.

Cela va montrer si le trafic organique augmente ou diminue, dans l’ensemble.

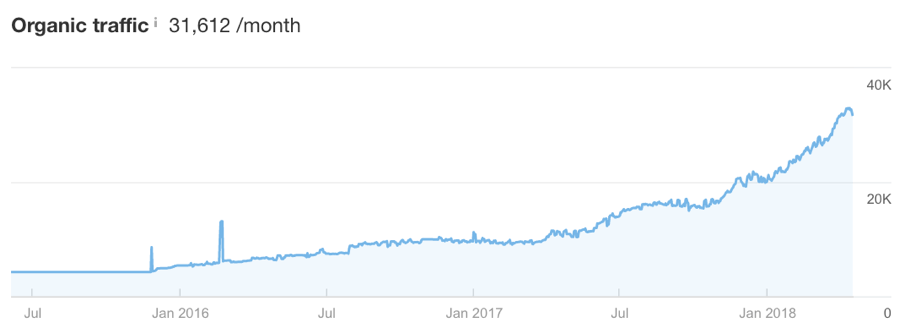

Ce graphique montre clairement que le trafic de recherche organique vers le blog d’Ahrefs augmente, mais ne diminue pas.

(Le trafic organique a triplé au cours des deux dernières années !)

Allez sur Site Explorer, puis entrez votre domaine et cliquez sur Afficher.

Ensuite, cliquez sur l’onglet Recherche organique.

Vous verrez un graphique de votre recherche organique estimée pour les dernières années (un peu comme Google Analytics !)

Enfin, voyons le trafic par semaine.

Nous allons rechercher les pics et les baisses de trafic les plus remarquables.

Dans cet exemple, nous pouvons voir quelques petites baisses de trafic à peu près au même moment chaque année – Noël !

C’est sans doute parce que la plupart des gens sont en train de s’amuser à Noël. Ils ne sont pas assis pour lire le blog d’Ahrefs !

Bien sûr, dans d’autres cas, une baisse du trafic peut être le signe d’une pénalité Google (comme indiqué précédemment.)

Remarque de l’éditeur

Pour les étapes 11, 12, 13 et 14, vous aurez besoin d’un compte Ahrefs. Si vous n’en avez pas encore, vous pouvez faire un essai de 7 jours pour 7 $.

Étape 11. Vérifiez si les classements vont dans la bonne direction

Google Analytics vous donnera le nombre de trafic de recherche organique que vous avez.

Mais, ce résultat ne montrera pas que votre classement progresse.

Utilisons le Site Explorer d’Ahrefs pour vérifier.

Allez sur Site Explorer, puis entrez un domaine et cliquez sur Affichage.

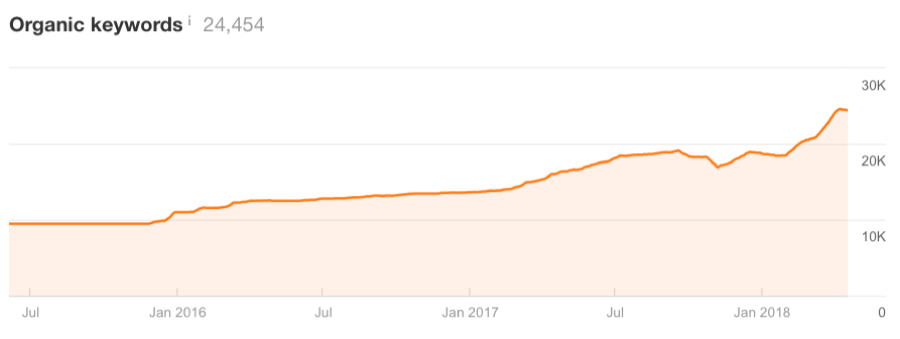

Cliquez sur l’onglet Recherche organique et jetez un œil sur les mots clés organiques.

Le graphique montre que les classements est en hausse ! Alors, il n’y a rien à craindre.

S’il affiche une baisse, alors votre classement diminue systématiquement.

Cela pourrait s’expliquer par de multiples raisons, dont un contenu obsolète, une pénalité Google, etc.

Dans ce cas, vous devrez approfondir votre recherche.

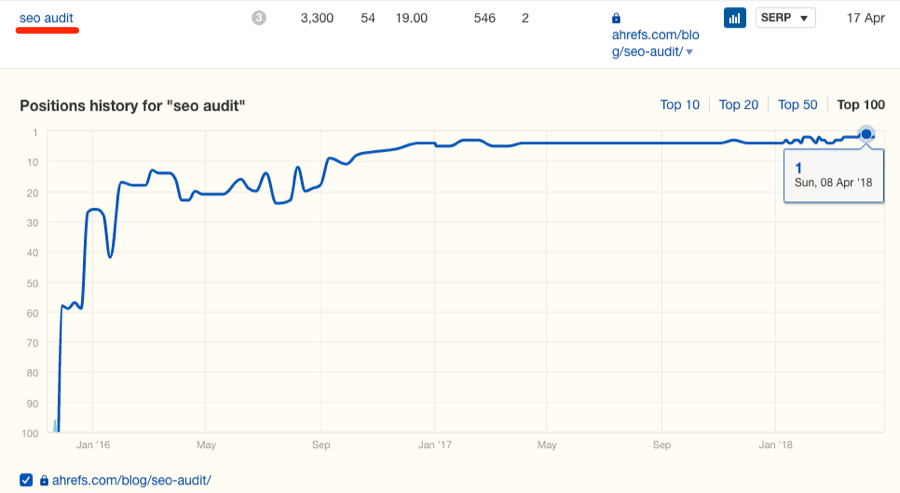

Avec le rapport de Mots clés organiques, vous pouvez également voir si les classements de Mots clés spécifiques vont dans la bonne direction.

Appuyez sur l’icône du graphique et vous verrez comment votre classement a changé au fil du temps.

Apparemment, nous avons déchiffré le classement des « audits SEO ! »

Et n’oubliez pas que si vous voulez suivre à long terme le classement de mots clés spécifiques, essayez Rank Tracker.

Étape 12. Recherchez les pages classées aux positions 5 à 10 pour les mots clés de volume recherche élevé

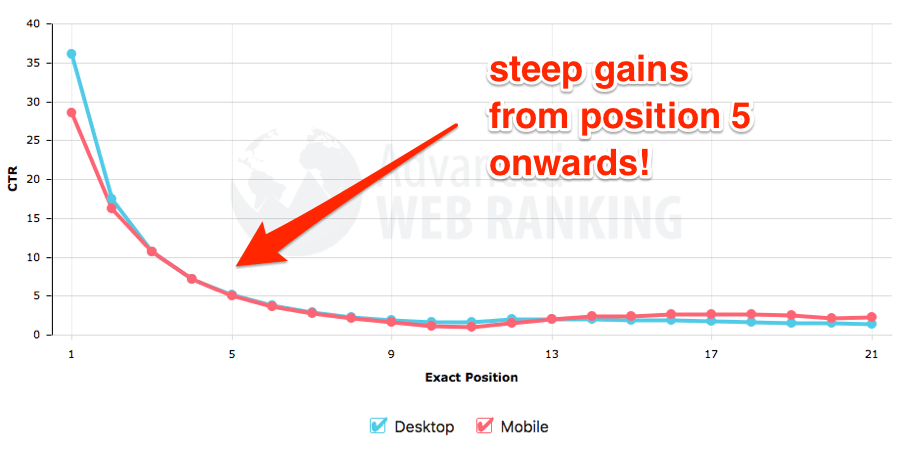

Classer en 5ème position pour les mots clés de volume de recherche élevé est déjà pas mal.

Mais si vous pourriez augmenter de quelques positions, vous verrez la différence sur votre trafic.

La bonne nouvelle est que si vous avez déjà un bon classement, un peu de référencement proactif devrait suffire pour vous pousser dans les premières positions.

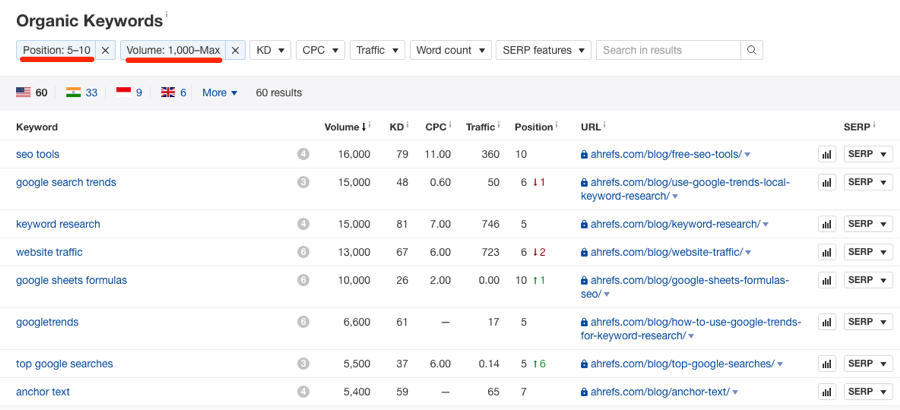

Alors, nous devons rechercher des mots clés de volume de recherche élevé qui vont nous classer aux positions 5 à 10.

Utilisons le Site Explorer d’Ahrefs pour les trouver.

Allez sur Site Explorer. Entrez le domaine et cliquez sur Recherche organique, puis Mots clés organiques, Position (5–10) et Volume (1K +)

Nous aurons ensuite une liste de mots clés (et de contenu) sur lesquels nous pouvons nous concentrer pour mieux nous classer rapidement.

Alors, comment pouvons-nous booster ces pages et les pousser dans les premières positions ?

Voici quelques options :

- Ajoutez plus de liens internes aux pages

- Créez de nouveaux backlinks vers les pages

- Mettez à jour et relancez le contenu

- Assurez-vous que la page est optimisée pour le mot clé exact

Étape 13. Analysez votre profil de backlink

Ensuite, nous allons utiliser Ahrefs pour auditer rapidement et manuellement le profil de lien du site.

Pour le moment, nous recherchons seulement les problèmes les plus remarquables.

Commençons par aller sur Site Explorer, puis Aperçu.

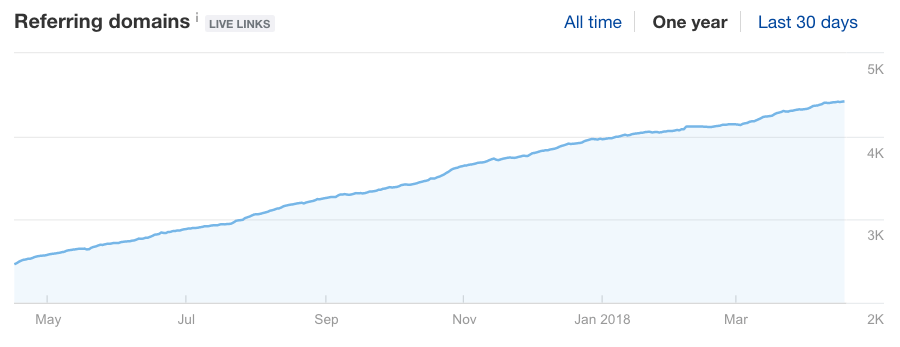

Tout d’abord, en regardant le graphique des domaines référents, nous voyons clairement que le nombre de domaines référents pointant vers le blog d’Ahrefs n’a pas cessé d’augmenter.

Alors, c’est bon !

S’il y a eu une baisse, je recommande de trouver la raison pour laquelle vous perdez des backlinks.

S’il s’agit de flatlining, eh bien, il peut être judicieux d’augmenter vos efforts pour créer des liens.

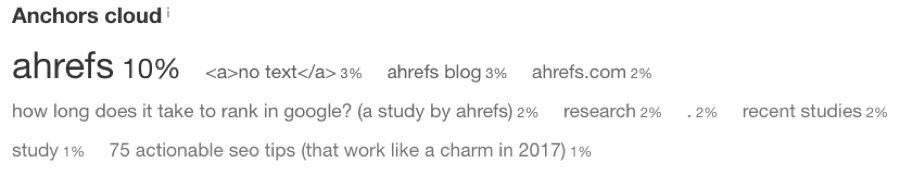

Défilons vers le bas jusqu’au Anchors Cloud pour voir rapidement et clairement comment le texte d’ancrage du site est distribué.

Dans cet exemple, nous pouvons voir que la plupart des backlinks sont liés à des ancres de marque ou génériques.

C’est une bonne nouvelle du point de vue SEO, car les liens de marque contribuent à renforcer la confiance.

Si vous aviez là un grand nombre d’ancres riches en mots clés ou spammées, vous devrez peut-être les examiner plus attentivement.

Mais heureusement dans cet exemple, nous avons des liens de marque.

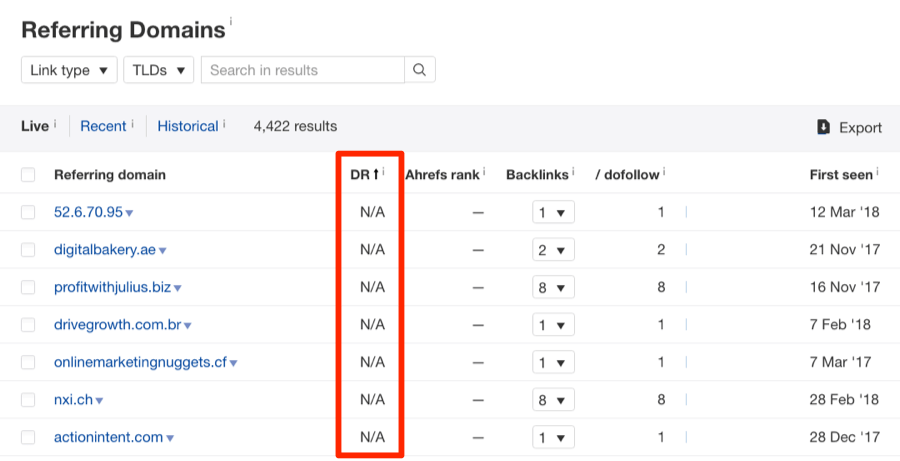

Enfin, nous allons nous pencher un peu plus attentivement sur les domaines référents du site.

Encore une fois, nous allons juste voir s’il y a quelque chose de suspect ou de mauvaise qualité.

Nous cliquons sur « DR » pour inverser l’ordre du rapport et placer les liens de très faible qualité en haut.

Allez sur Site Explorer, puis entrez un domaine. Cliquez sur Profil de backlink, Domaines référents et triez par DR (la plus faible qualité en premier).

Remarques : tous les liens à faible DR ne sont pas tous de mauvaise qualité ou spammés. Certains peuvent être des liens légitimes qui aident votre site à se classer. Soyez donc prudent si vous prévoyez de désavouer l’un de ces liens !

Consulter notre article pour découvrir les liens toxiques à désavouer automatiquement.

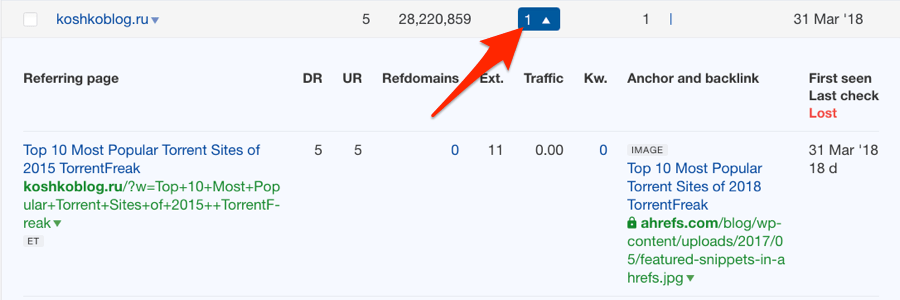

Si quelque chose vous semble suspect, cliquez sur le numéro dans la colonne Backlinks, puis cliquez sur l’URL du lien pour vérifier.

Vous pouvez passer du temps à bien le vérifier lorsque vous faites un audit complet.

Mais pour le moment, recherchez tout ce qui est de mauvaise qualité ou délibérément manipulateur.

Recherchez aussi des signes évidents de « SEOing » (c’est un mot, d’accord !).

A titre d’exemple, il y a de nombreux posts d’invités de mauvaise qualité ou des liens provenant de tonnes de répertoires non pertinents.

Dans cet exemple, le profil du lien semble relativement bon. Passons donc à la prochaine étape de notre audit SEO.

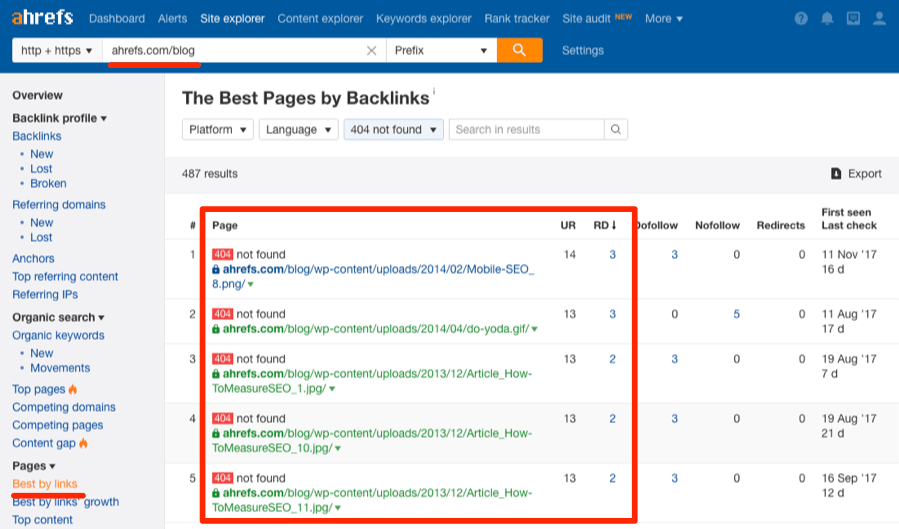

Étape 14. Recherchez et corrigez les liens brisés vers (et depuis) votre site

Les pages (et les liens) cassées sur votre site gaspillent ce qu’on appelle « link equity » ou jus de liens.

Ainsi, vous devez trouver et résoudre ces problèmes dès que possible.

Pour trouver des pages cassées, allez sur :

Site Explorer, puis Pages ensuite Best by links et ajoutez un filtre « 404 ».

Triez les résultats par DR (domaines référents) pour voir quelles pages cassées ont le plus de liens entrants.

Parcourez cette liste et corrigez les erreurs le cas échéant.

Pour ce faire, vous devez soit :

- remplacer le contenu ;

- rediriger la page cassée ou brisée (vers une autre page active et pertinente) ;

- laisser la page redirigée vers erreur 404 (c’est bien pour les pages sans backlinks).

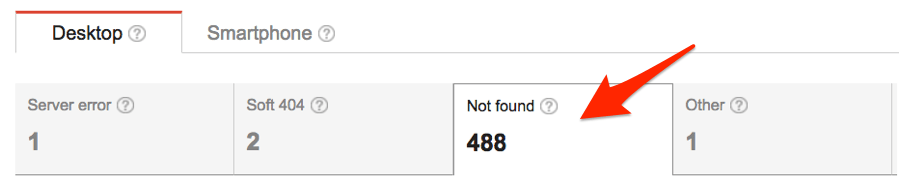

Vous n’utilisez pas Ahrefs ou SEMrush ? Alors, essayez ceci…

Allez sur Google Search Console, puis Crawl ensuite Erreurs Crawl.

Vous allez voir toutes les erreurs « not found » (c’est-à-dire 404) sur votre site.

Cependant, vous ne pourrez pas voir combien de liens pointent vers chacune de ces pages cassées si vous n’avez pas un compte Ahrefs.

Alors, tout ce que vous avez à faire, c’est de les réparer tous.

Puis, assurez-vous qu’il n’y a plus de liens brisés sur votre site Web.

Voici un exemple de lien brisé sur le blog d’Ahrefs :

Ces liens brisés contribuent à une mauvaise expérience utilisateur et diluent également le PageRank.

Donc, il faut les supprimer ou remplacer.

Étape 15. Trouvez les « lacunes de contenu »

Qu’est-ce qu’une lacune de contenu ?

C’est un mot clé pour lequel vos concurrents se classent actuellement, mais que vous ne l’utilisez pas encore pour vous classer.

Vous devriez corriger cette lacune en utilisant ce mot clé.

Il y a un simple rapport que vous pouvez exécuter dans le Site Explorer d’Ahrefs pour trouver les lacunes de contenu.

Nous l’avons appelé astucieusement Content Gap.

Mais avant toute chose, vous devriez savoir qui sont vos concurrents les plus proches que vous devriez rechercher.

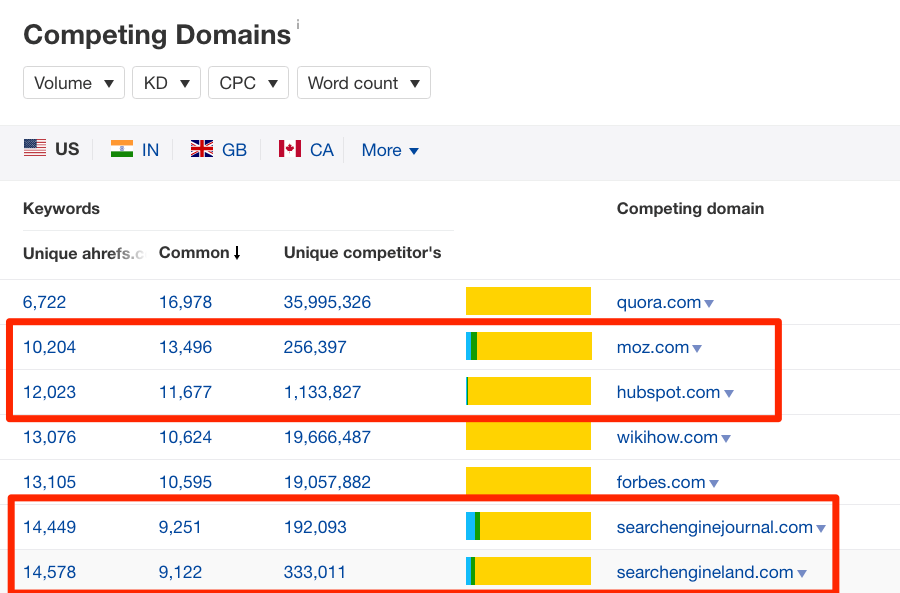

Pour cela, exécutez le rapport Domaines concurrents.

Allez sur Site Explorer, entrez le domaine, cliquez sur Recherche organique ensuite Domaines concurrents.

Le rapport va montrer les sites auxquels votre domaine a eu un grand chevauchement dans le classement des mots clés.

Ignorez les sites de type e-commerce comme ebay ou Amazon, ainsi que les « grands » sites génériques comme Quora ou Forbes.

J’ai passé en revue le rapport Domaines concurrents pour le blog d’Ahrefs. Puis, j’ai cueilli nos trois sites que je considère comme des concurrents proches.

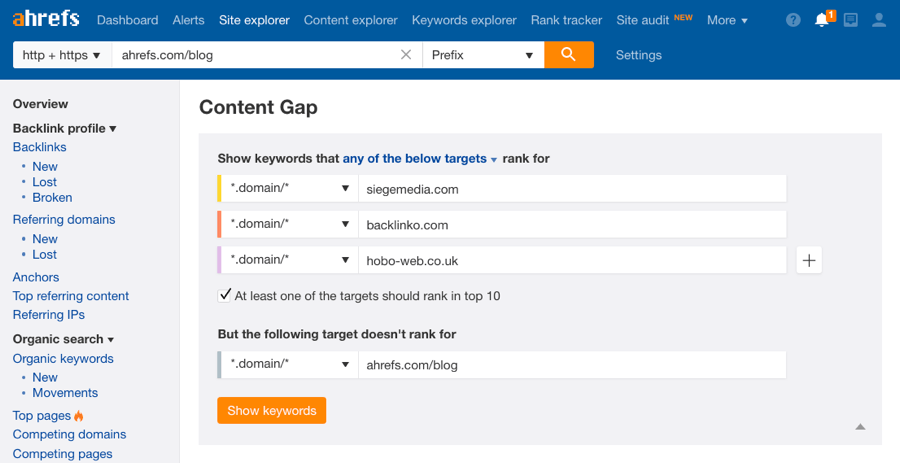

Je vais maintenant sur le rapport Content Gap et saisir ces trois concurrents.

Allez sur Site Explorer, entrez un domaine, cliquez sur Recherche organique et Lacune de contenu. Saisissez les concurrents ensuite cliquez sur Afficher les mots clés.

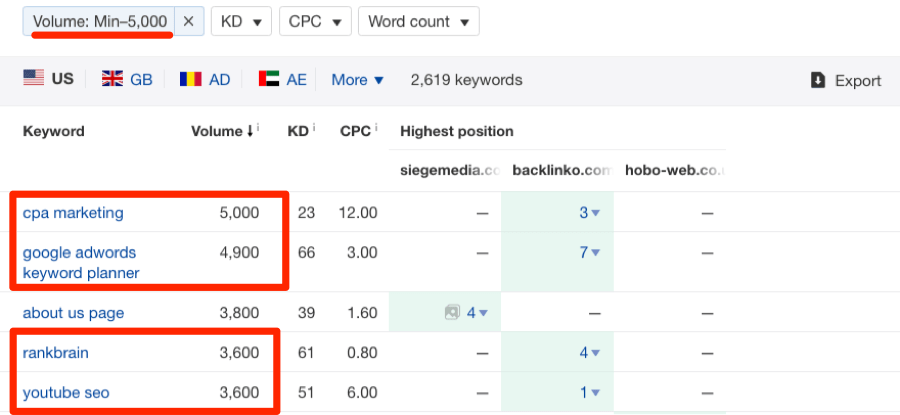

J’ai aussi filtré le volume pour afficher les mots clés avec un volume de recherche maximal de 5 000.

Ainsi, nous filtrons les recherches de marque et les autres mots clés qui ne valent pas la peine d’être ciblés.

Tout de suite, nous pouvons voir les mots clés à volume de recherche élevé qui en valent la peine d’être ciblés.

Remarque : Si vous avez une boutique e-commerce, ce résultat peut aussi vous donner de bonnes idées sur les nouveaux produits à stocker.

Si vous manquez d’idées, filtrez et répétez ce processus avec encore plus de concurrents !

Étape 16. Effectuez un audit complet de contenu

La dernière étape de notre processus d’audit n’est pas très intuitive, parce qu’elle implique souvent de supprimer certaines pages de votre site.

Comment la suppression des pages contribuera-t-elle à augmenter le trafic de recherche ?

La réponse est simple : de nombreuses pages de mauvaise qualité (ou peu performantes) peuvent tirer le classement de l’ensemble de votre site vers le bas.

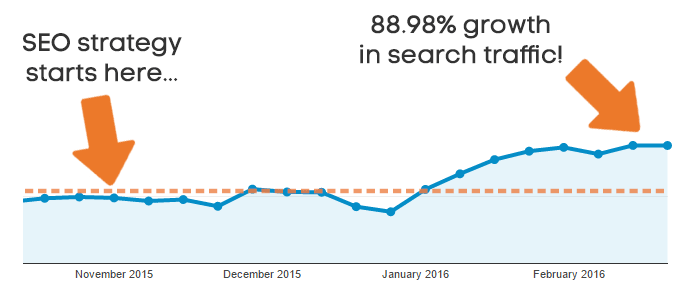

Il y a quelques années, nous avons supprimé plus de 200 articles peu performants du blog d’Ahrefs. Nous avons rapidement constaté une belle augmentation de notre trafic de recherche.

Pour résumer, voici notre stratégie :

- Trouvez des pages de faible qualité avec peu ou pas de trafic de recherche organique ;

- S’il est possible de les améliorer, mettez-les à jour et relancez-les ;

- Sinon, supprimez-les et utilisez 301 pour redirigez l’URL vers une autre page appropriée.

C’était encore plus de succès lorsque nous avons fixé les pages de mauvaise qualité pour une seconde fois !

Un mot d’avertissement, toutefois :

Soyez très prudent lorsque vous fixez votre site.

Vous devez d’abord penser à opter pour une solution qui devrait améliorer le contenu et le relancer.

Sauf, si quelque chose est de mauvaise qualité et ne vaut pas la peine d’être mis à jour, continuez et supprimez-la. Assurez-vous simplement de configurer une redirection 301 vers une page pertinente pour ne perdre aucun jus de lien.

CONSEIL DE PRO

Vérifiez aussi si plusieurs éléments du contenu ciblent le même mot clé.

C’est ce qu’on appelle la « cannibalisation des mots clés ».

Idéalement, chaque page de votre site devrait cibler un seul mot clé.

Une bonne option consiste à combiner plusieurs articles ciblant le même mot clé en un seul article faisant autorité. Nous avons récemment fusionné deux articles en un seul pour créer notre guide sur la création de liens brisés.

Et… Voila !

L’audit SEO est terminé !

En suivant ces étapes, vous devriez découvrir de nombreuses modifications que vous pouvez apporter à votre site pour améliorer votre classement.

Un audit SEO complet est un processus beaucoup plus long. Cela prend de quelques heures à quelques jours, selon la taille du site. Mais, notre processus est un excellent moyen de démarrer une nouvelle campagne SEO. Il permet aussi d’avoir une idée de la façon dont un site est actuellement configuré.

Si vous voulez en savoir plus, vous pouvez maintenant revenir au rapport d’analyse (dans Site Audit) et analyser plus en détail la structure du site, les liens internes, etc.

Vous pouvez aussi revenir au Site Explorer pour bien examiner le profil de lien de votre site et rechercher plus d’opportunités de mots clés dans Mots-clés Explorer.

Mais, pour le moment, nous allons laisser ça pour un autre jour …

Si vous avez des questions sur le processus d’audit ou que vous avez des conseils à partager, n’hésitez pas à laisser un commentaire ci-dessous.

- Comment utiliser Google My Business ? Le guide ultime - 10 mars 2023

- Comment vendre des cours en ligne et faire 10 000 € / mois ? - 9 mars 2023

- Windows Server 2022 vs Windows Server 2019 : Comparaison des fonctionnalités - 19 janvier 2023

Tophebergeur Blog Articles et Tutoriels Tophebergeur

Tophebergeur Blog Articles et Tutoriels Tophebergeur